视觉能力媲美OpenAI,Meta发布Llama 3.2

Meta的大语言模型Llama发布了最新版本。

在日前召开的Meta Connect大会上,Meta推出了Llama 3.2,也是它首款能够理解图像和文本的旗舰视觉模型。

Llama 3.2包含中型和小型两个版本(分别拥有11B与90B参数),以及更轻量化的纯文本模型(分别拥有1B与3B参数),后两款主要面向特定移动与边缘设备。

Meta公司CEO扎克伯格在开幕主题演讲中表示:“这是我们的首个开源多模态模型,它将支持多种需要视觉理解的应用场景。”

与前代版本一样,Llama 3.2将支持12.8万个token的上下文长度,这意味着用户可以输入大量文本(相当于数百页教科书的内容)。更高的参数量,往往也表明模型的准确率更高,能够处理更为复杂的任务。

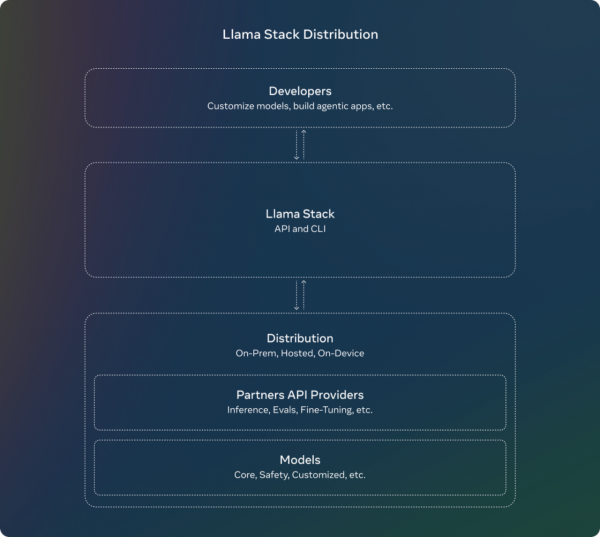

Meta还首次分享了官方的Llama技术栈发行版,以便开发人员可以在各种环境下使用这些模型,包括本地、设备端、云端和单节点场景。

扎克伯格表示:“开源将成为最具成本效益、可定制、值得信赖且性能最高的选择。我们已经迎来了行业转折点,它开始成为行业标准,堪称是AI领域的Linux。”

与Claude及GPT4o正面对垒

Meta在两个月前刚刚发布了Llama 3.1。该公司表示,这套模型截至目前已经实现了10倍发展。

扎克伯格强调:“Llama继续快速改进,正在实现越来越多的新功能。”

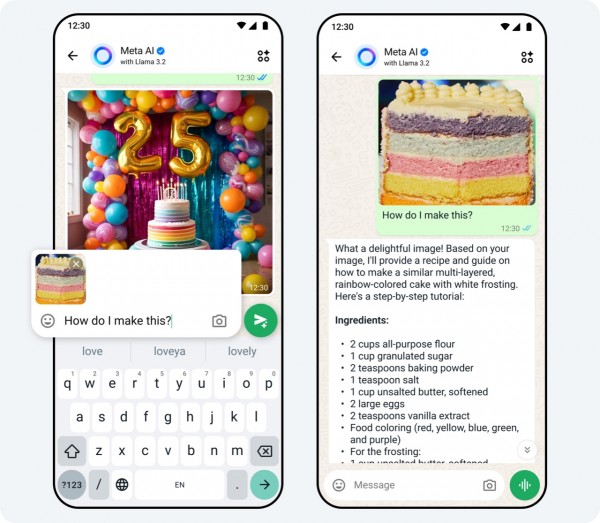

如今,两个最大的Llama 3.2模型(11B与90B)已能支持图像用例,并且能够理解图表与图形、为图像添加标题并从自然语言描述当中精确定位对象。例如,用户可以询问自己的公司在哪个月的销售情况最好,模型则根据可用的图表推理出答案。这两个大模型还可以从图像中提取细节以创建标题。

与此同时,两个轻量级模型则可以帮助开发人员在个人环境中构建个性化智能体应用——例如总结最近的消息,或者发送日历邀请并组织后续会议。

Meta表示,Llama 3.2在图像识别和其他视觉理解任务上的表现,已经能够与Anthropic的Claude 3 Haiku以及OpenAI的GPT 4o-mini相媲美。不止如此,它在指令遵循、总结、工具使用和提示词重写等领域的表现还优于Gemma和Phi 3.5 -mini模型。

Llama 3.2模型目前已经在llama.com、Hugging Face以及Meta各合作伙伴的平台上开放下载。

栩栩如生的名人语音

Meta还在着手扩展AI商业应用,以便企业能够在WhatsApp和Messenger上使用点击消息广告,通过智能体为常见问题生成答案、讨论产品细节并完成购买操作等。

Meta声称,超过100万家广告商正在使用它的生成式AI工具, 上个月由这些工具制作的广告已经超过1500万条。Meta报告称,与未使用生成式AI的广告宣传相比,使用Meta生成式AI技术的广告内容平均点击率要高出11%,转化率则高出7.6%。

最后,对于消费者来说,Meta AI现在还拥有了“语音”——而且是多种语音选项。新的Llama 3.2支持Meta AI中的全新多模态功能,而且能够以名人的音色做出回应,具体包括朱迪·丹奇女爵士、约翰·塞纳、基冈·迈克尔·基、克里斯汀·贝尔和奥卡菲娜。

扎克伯格在主题演讲中指出:“我认为语音是一种比文本更自然的AI交互方式,而且效果真的好很多。”

该模型将以名人的音色在WhatsApp、Messenger、Facebook和Instagram上响应语音或者文本命令。Meta AI还能根据聊天中分享的照片生成回复,包括添加、删除或更改图像以及添加新背景。Meta方面表示,他们还在Meta AI当中试验新的翻译、视频配音与口型同步工具。

扎克伯格最后放出豪言,称Meta AI有望成为世界上使用率最高的助手——“它可能已经做好了准备”。

来源:至顶网